Открываешь ленту — Лекс выкладывает 4.5-часовой разговор с двумя из самых ясных умов в ML: Sebastian Raschka (автор книг по LLM с нуля) и Nathan Lambert (тот, кто умеет объяснять scaling и agents без воды). Видео на X, YouTube, Spotify — и timestamps на 4+ страницы. Это не просто подкаст. Это State of the Union для AI в начале 2026-го: где мы, куда летим, кто выиграет, и почему 72-часовые недели — это уже норма.

Сидишь, слушаешь — и понимаешь: мы уже не в «будущем AI». Мы в середине взрыва. Вот ключевые тезисы, которые теперь крутятся в голове как мантры.

Here's my conversation all about AI in 2026, including technical breakthroughs, scaling laws, closed & open LLMs, programming & dev tooling (Claude Code, Cursor, etc), China vs US competition, training pipeline details (pre-, mid-, post-training), rapid evolution of LLMs, work… pic.twitter.com/AeGxRWjJF6

— Lex Fridman (@lexfridman) January 31, 2026

Timestamps:

0:00 — Вступление

1:57 — Китай против США: кто победит в гонке за ИИ?

10:38 — ChatGPT против Claude против Gemini против Grok: кто лидирует?

21:38 — Лучший ИИ для программирования

28:29 — Open Source против Closed Source LLM

40:08 — Трансформеры: эволюция больших языковых моделей с 2019 года

48:05 — Законы масштабирования ИИ: мертвы или всё ещё работают?

1:04:12 — Как обучают ИИ: Pre-training, Mid-training и Post-training

1:37:18 — Post-training в деталях: самые интересные новые направления исследований в LLM

1:58:11 — Советы новичкам: как войти в разработку и исследования ИИ

2:21:03 — Рабочая культура в ИИ (72+ часа в неделю)

2:24:49 — Пузырь Кремниевой долины

2:28:46 — Модели текстовой диффузии и другие новые направления исследований

2:34:28 — Использование инструментов (tool use)

2:38:44 — Непрерывное обучение (continual learning)

2:44:06 — Длинный контекст (long context)

2:50:21 — Робототехника

2:59:31 — Таймлайн до AGI

3:06:47 — Заменит ли ИИ программистов?

3:25:18 — Умирает ли мечта об AGI?

3:32:07 — Как ИИ будет зарабатывать деньги?

3:36:29 — Крупные поглощения в 2026 году

3:41:01 — Будущее OpenAI, Anthropic, Google DeepMind, xAI, Meta

3:53:35 — Манхэттенский проект для ИИ

4:00:10 — Будущее NVIDIA, GPU и кластеров вычислений для ИИ

4:08:15 — Будущее человеческой цивилизации

Геополитика и гонка (0:00–1:57 и дальше)

- China vs US: кто победит? Не просто «кто больше compute». Китай имеет преимущество в данных (цензура как фильтр), энергии и скорости развертывания. США — в талантах, open research и экосистеме (NVIDIA, startups). Но если Китай догонит по chip’ам и energy — game over. Многие теперь ставят на hybrid: US лидирует в frontier, Китай — в applied и mass adoption.

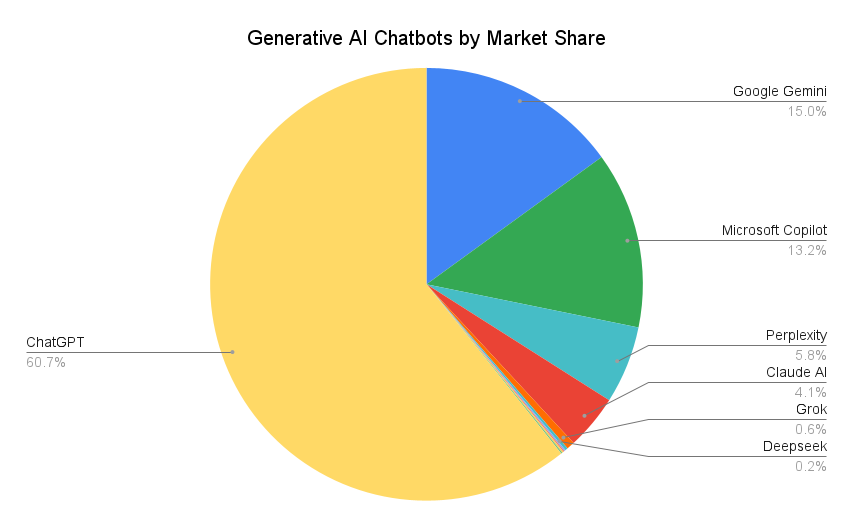

- ChatGPT vs Claude vs Gemini vs Grok: кто лидирует? 2026 — это уже не одна модель. Claude доминирует в coding и reasoning (особенно с tool use). Gemini — multimodal king. Grok — edge в uncensored + real-time. OpenAI держит mass market. Но никто не «победил» — все в 1–2 шагах друг от друга. Разница в пост-тренинге и inference tricks.

Coding & Dev tooling (21:38+)

- Лучший AI для кодинга: Claude Code / Cursor / Devin-style agents. 2026 — год, когда программист без AI-tooling выглядит как механик без динамометрического ключа. Cursor + Claude — это уже 3–5× productivity. Но настоящая магия — agents, которые self-correct и chain tools.

- Will AI replace programmers? Нет, но заменит «плохих» программистов. Хорошие станут conductors: prompt engineering + verification + architecture. Плохие — вытеснены. Dream AGI не умирает — он эволюционирует в agentic workflows.

Технические глубины (40:00+)

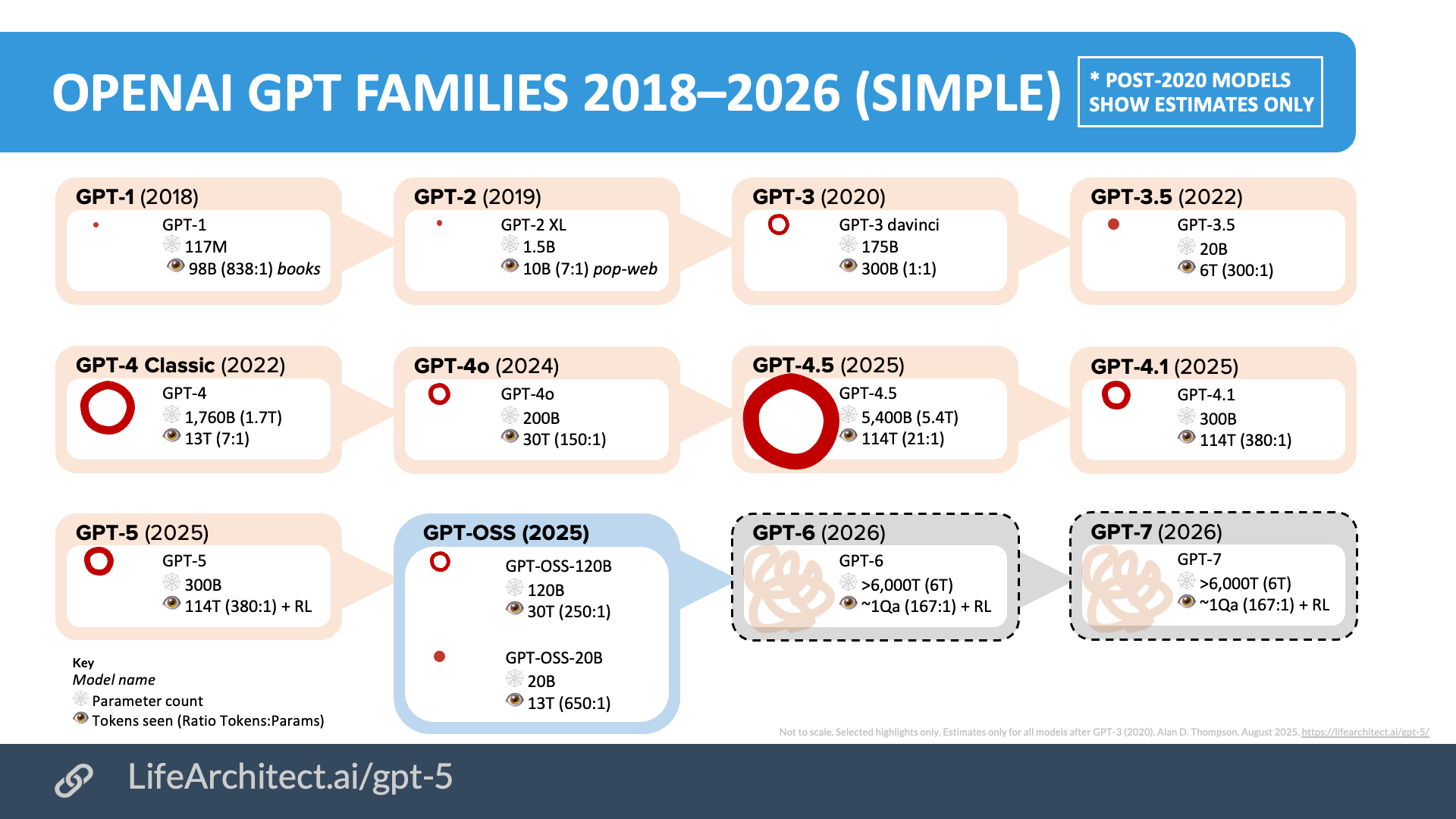

- Transformers с 2019: эволюция. От vanilla GPT до MoE, mixture-of-experts, test-time compute, RLVR (reinforcement learning with verifiable rewards) — inference scaling стал новым pre-training.

- Scaling laws: dead or alive? Не мертвы, но изменились. Chinchilla умерла, теперь — post-training scaling, inference-time scaling, data quality over quantity. Laws hold, но в другой форме.

- Training pipeline: Pre / Mid / Post-training. Pre — raw next-token prediction. Mid — alignment, reasoning chains, synthetic data loops (самый underrated кусок 2026: здесь рождаются breakthroughs). Post — RLHF, DPO, rejection sampling, tool-use fine-tuning. Post-training — это новая research frontier: где модели учатся думать дольше, self-correct, использовать tools.

- Новые направления: text diffusion, continual learning, long context (миллионы токенов уже норма), tool use (agents как default).

Роботика, compute, timelines (2:50+)

- Robotics: humanoid wave (Optimus, Figure, 1X). Vision-only + scaling → rapid progress. 2026–2028 — первые полезные home/work robots.

- Compute: NVIDIA всё ещё король, но clusters в 100k+ H100/H200 — норма. Energy bottleneck → nuclear/SMR must-have. TPUs/Google custom silicon догоняют.

- AGI timelines: 2027–2030 (многие теперь ближе к 2027–2028). Риски: misalignment, power concentration, geopolitical escalation. «How stuff might go wrong» — отдельный блок: от slow takeoff до sudden capabilities jump.

Культура, деньги, будущее (2:21+)

- Work culture: 72+ hour weeks — реальность в top labs. Silicon Valley bubble: да, но bubble не лопается — он мутирует в AI-native economy.

- Как AI будет зарабатывать: subscriptions + API + agents-as-service + robotics-as-a-service. Big acquisitions 2026: ждём (xAI? Anthropic? Meta buys?).

- Future of labs: OpenAI, Anthropic, DeepMind, xAI, Meta — все в гонке. Manhattan Project for AI — уже происходит (неофициально).

- Future of human civilization: от abundance до existential questions. AI как инструмент или как новый вид?

1. Экспоненциальный рост производительности frontier AI-моделей (логарифмическая шкала, семьи GPT от OpenAI 2018–2026 — отличная иллюстрация scaling в новой форме)

2. Главные bottleneck развития AI в 2026 году (пример роста энергопотребления дата-центров под AI — energy и compute как основные стены, как обсуждали в подкасте)

3. Распределение влияния ведущих LLM в 2026 году (реальная доля трафика/рынка generative chatbots на февраль 2026 — ChatGPT всё ещё доминирует, но гонка плотная)

4. Сдвиг фокуса: от pre-training к post-training и inference scaling (пирамида навыков AI-исследователей 2025–2026 — показывает, куда ушёл основной research effort: applied, frontier, post-training)

5. Распределение прогнозов по срокам достижения AGI (снимок 2026) (кумулятивные вероятности от разных источников — пик в 2027–2030, как и в подкасте, с urgency на ближайшие годы)

Алексей Олин, управляющий партнёр iVenturer Fondation, бывший директор по развитию РТ-Интеграция и Фонда РУСНАУКА:

Самое тонкое, что осталось после: мы уже не в эпохе «scaling laws мертвы/живы». Мы в эпохе, где scaling просто сменил адрес — теперь он в mid/post-training, inference-time compute и в том, как долго модель «думает» перед ответом (RLVR, self-correction, tool-chaining). o1-style reasoning не баг, а новая норма. Pre-training — это уже фундамент, на котором строят дворцы из пост-тренинга.

Китай vs США? Не про чипы (хотя да, bottleneck). Про скорость итераций и willingness платить цену (72+ часовые недели, energy bets, data filtering). США пока выигрывают в open research и талантах, но если Китай прорвёт energy wall или mass-deploy agents — баланс качнётся.

Claude/Cursor как coding king 2026 — это не инструмент, это уже новый способ думать кодом. Программист без такого стека выглядит как механик без диагностики.

AGI timelines 2027–2028 (многие теперь ближе к нижней границе) — это не хайп. Это когда inference scaling + robotics + long context сольются в нечто, что уже не «помогает», а просто делает.

Если в 2026 мы всё ещё обсуждаем «заменит ли AI программистов» — мы опаздываем на цикл. Вопрос уже другой: «Как построить так, чтобы быть тем, кто пишет conductor layer над agents, а не тем, кого они заменяют?»

Спасибо Лексу, Sebastian и Nathan — это не подкаст. Это State of the Union для тех, кто строит, а не просто скроллит.

Личный тейк после прослушки

Это не «ещё один подкаст». Это карта 2026-го: где bottlenecks (energy, data quality, alignment), где alpha (mid/post-training, inference scaling, agents), где риски (geopolitics, work culture burnout). Для новичков: совет Raschka — строй маленькие модели с нуля (SmolLM-style), пиши код, читай papers. Lambert — фокус на agents и tool use.

Вопрос, который теперь не отпускает: Если в 2026 мы уже обсуждаем inference-time scaling и mid-training как основные драйверы — что будет в 2027, когда кто-то прорвёт energy wall или запустит 10M-token context в production?

Слушать обязательно. Не потому что «интересно». Потому что это уже не будущее — это расписание на ближайшие 12–24 месяца.

Материал подготовлен и опубликован редакцией медиа-центра iVenturer Foundation.

Больше материалов:

->> Инфографика и визуализации

->> Архив матералов на русском языке

->> Архив материалов на английскоам языке